Come dominare gli Agenti AI

Come dominare gli Agenti AI?

Questo articolo esplora la necessità di una visibilità del ragionamento all’interno degli agenti di intelligenza artificiale, sottolineando come il processo logico sia rilevante tanto quanto il risultato finale.

Per dominare gli agenti AI, è fondamentale comprendere il ragionamento interno e per farlo è necessario rendere visibile le modalità di ragionamento, in quanto il percorso seguito per arrivare a una risposta è importante quanto la risposta stessa.

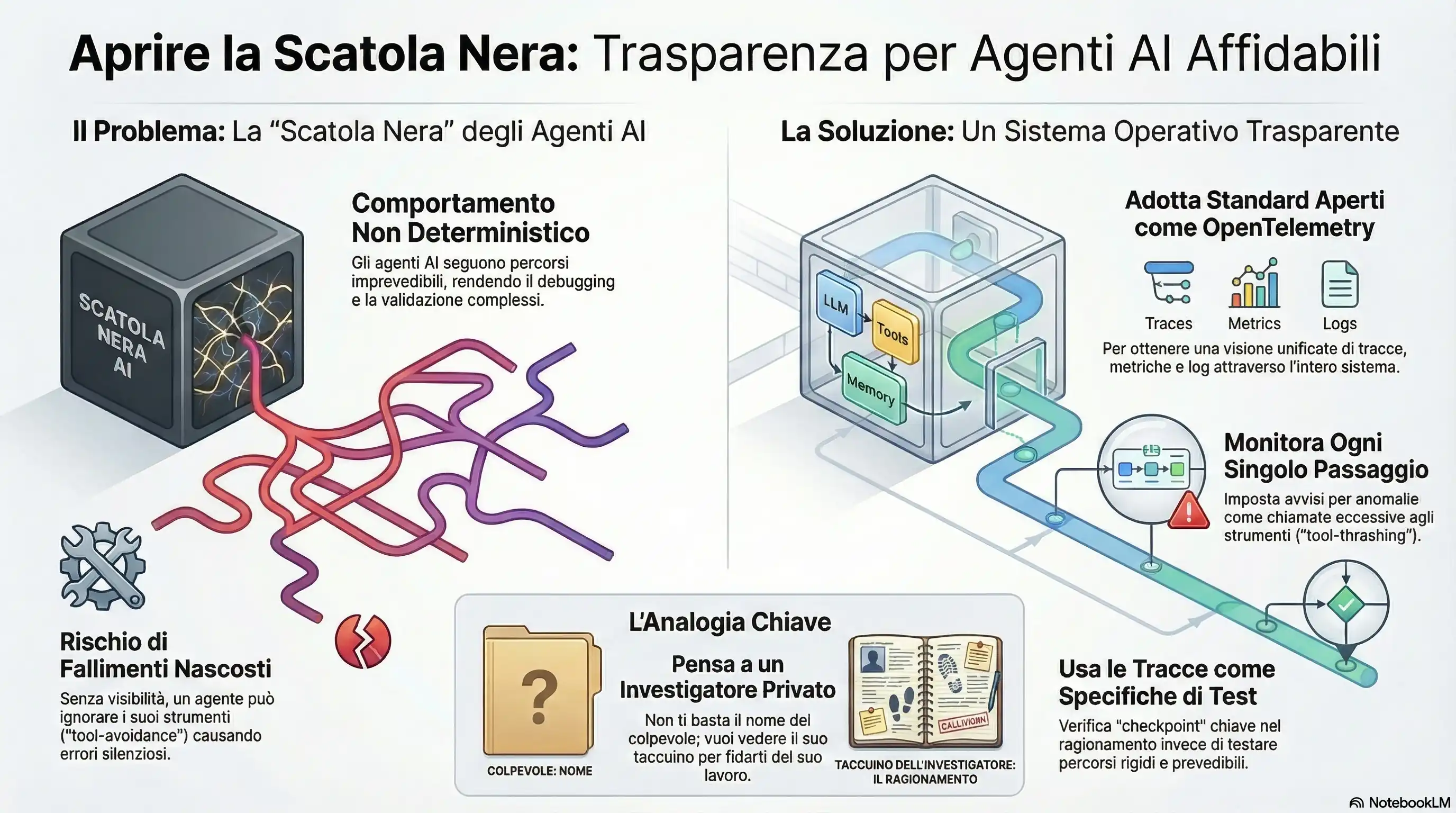

Gli Agenti AI non sono deterministici.

Poiché gli agenti combinano LLM, strumenti e cicli di ragionamento, il loro comportamento è non deterministico, ossia gli agenti non seguono percorsi prevedibili, rendendo l’ingegneria di questi sistemi profondamente diversa dal software classico.

La visibilità del ragionamento:

Rendere visibile o prendere visione del ragionamento di un Agente AI è necessario per questi motivi:

- Prevenzione dei fallimenti nascosti: esporre il ragionamento permette di vedere quali strumenti sono stati invocati, in quale contesto e per quale motivo. Con questa visibilità, si possono verificare immediatamente eventuali errori dell’agente. Ad esempio, un LLM potrebbe iniziare a rispondere direttamente all’utente invece di utilizzare gli strumenti previsti (tool-avoidance) e questo problema è rilevabile solo ispezionando log e telemetria in tempo reale.

- Adozione di standard aperti: per ottenere una visione unificata dei flussi di lavoro (sia per singoli agenti che multi-agente), è possibile usare ad esempio OpenTelemetry, uno standard open per analizzare metriche che permette di monitorare tracce, metriche e log attraverso tutte le chiamate agli strumenti e le interazioni degli orchestratori.

- Monitoraggio granulare e avvisi: è essenziale trasmettere tracce a livello di singolo passaggio (pianificazione, chiamate a strumenti, passaggi di consegne tra agenti) sia in fase di sviluppo che in produzione al fine di identificar questi comportamenti rrati: ◦ Tool-avoidance: quando l’LLM risponde direttamente ignorando gli strumenti necessari. ◦ Tool-thrashing: quando si verificano cicli o chiamate eccessive agli strumenti.

- Le tracce come specifiche di test: le tracce del ragionamento non dovrebbero essere considerate solo artefatti per il debug, ma vere e proprie specifiche su cui eseguire test. Poiché gli agenti non seguono percorsi prevedibili, il testing deve evolvere dalla validazione di percorsi rigidi alla verifica di “checkpoint” basata sui pattern riscontrati nei log e nelle tracce (ad esempio, verificare che un determinato strumento sia stato chiamato almeno una volta).

- Osservabilità come pilastro operativo: la creazione di agenti pronti per la produzione riguarda meno la scelta del LLM perfetto e più la costruzione di un robusto telaio operativo. Questo implica gestire il non-determinismo attraverso nuove forme di osservabilità e governance, rendendo gli ID delle tracce elementi di primo piano nei piani di gestione degli incidenti.

In sintesi, la visibilità del ragionamento è invertita: non si tenta più di comprendere cosa succede dentro la scatola nera ma viene analizzato il flusso delle decisione prese dalla scatola nera attraverso la sequenza di utilizzo degli strumento e le risposte date, permettendo di correggere derive nei prompt o nelle policy prima che causino problemi su larga scala.

Per capire meglio questo concetto, immagina un agente AI come un investigatore privato: non ti basta sapere chi secondo lui è il colpevole (il risultato finale), ma vuoi vedere il suo taccuino per capire quali indizi ha raccolto e quali testimoni ha interrogato (il ragionamento), così da essere certi che non abbia semplicemente tirato a indovinare.